Critiques de René Thom (5)

« Stabilité structurelle et morphogenèse » du mathématicien français René Thom (1923-2002) est le premier, je crois, ouvrage destiné au grand public sur la théorie des catastrophes (1977, Interéditions, 382 p.), réédité plusieurs fois par la suite.

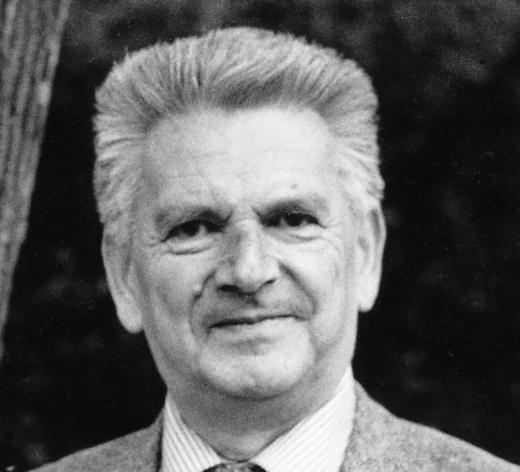

René Thom est un jurassien d’origine, qui passe par l’Ecole Normale Supérieure, avant d’obtenir son doctorat en 1951 à Paris sous la direction, et la canalisation, d’Henri Cartan. Il sera professeur à la Faculté des Sciences de Strasbourg de 1954 à 1963. Recevant une Medal Fields en 1958 sur la topologie différentielle, avant d’intégrer l’« Institut des Hautes Etudes Scientifiques » (IHES) de Bures-sur-Yvette de 1963 à 1990. Il y est en bonne compagnie, puisqu’il y a là Alexandre Grothendieck, puis Pierre Deligne et Alain Connes, tous Medal Fields. C’est vraiment l’âge d’or de ce centre des sciences. Pour ce qui concerne Grothendieck, j’ai récemment relu et commenté les deux tomes de son ouvrage « Récoltes et Semailles » un pavé de 2000 pages (2023, Gallimard, 1506 p.).

Dans « Stabilité structurelle et morphogenèse », René Thom expose sa théorie des catastrophes, en termes simples, avant de diriger le « Séminaire de philosophie et mathématiques », à partir de 1972 à l'ENS. Le but était de confronter les idées sur les rapports entre philosophie et mathématiques. Entre autres, il était également invité d’honneur de l’« Oulipo ».

L’ouvrage est articulé autour de quatre thèmes, mathématique, scientifique au sens large, épistémologique et philosophique.

La partie mathématique est relativement simple à comprendre. Il identifie sept types de catastrophes élémentaires, suivant le nombre de paramètres impliqués, et donc le degré de la courbe qui contrôle le potentiel d’un système. Ce dernier est facile à conceptualiser. Une courbe du second degré (n = 2), par exemple une parabole, admet un seul point minimum. Pour simplifier, on choisira une courbe à concavité vers le bas. Ce point minimum va représenter le point se stabilité du système. Par contre, si on considère une courbe de degré quatre (n = 4), elle possède deux points minimum, séparés par un maximum. Il suffit d’imaginer une bille roulant sur cette courbe. Le maximum est un point instable. Par contre, les deux minima peuvent être considérés comme stables, à condition que l’on ne vienne pas perturber la bille.

Passant de la courbe unidimensionnelle V = f(x) à la surface V = f(x, y), on obtient ainsi les sept formes de « catastrophes » possibles, suivant leur degré et le nombre de paramètres que sont les coefficients des équations, qui contrôlent les minima des courbes. On a ainsi le pli, la plus simple des formes en degré 3 à 1 paramètre. Si deux paramètres existent, et que la courbe est de degré 4, il s’agit d’une fronce. Pour trois paramètres en entrée, et une variable, il s’agit de la queue d’aronde. Pour deux variables, c’est un ombilic hyperbolique (vague) ou elliptique (poil) selon son comportement à l’infini. Enfin, pour quatre paramètres on aura un papillon si c’est une courbe, à une variable ou un champignon, ombilic parabolique si c’est une surface. Avec plus de paramètres, d’autres formes de catastrophes distinctes apparaissent.

On constate donc de suite que le nombre de variables (x) ou (x, y) va déterminer si c’est une courbe ou une surface. Par contre, le nombre de paramètres joue sur le nombre et position des points d’équilibre ou d’instabilité, suivant la concavité des courbes.

Et c’est là que tout est parti en catastrophe, c’est le cas de le dire. La théorie de René Thom est essentiellement une description mathématique d’un passage entre deux situations, c’est la description d‘une bifurcation dynamique. Le système passe brutalement d’un état à un autre, c’et la notion de catastrophe. Par contre, dire que c’est un pli, une fronce ou un papillon, n’a aucun rapport avec l’évolution des paramètres. Ou du moins leur mode d’évolution. Un pli, par exemple, n’implique pas que le système se replie sur lui-même. Ce sont les paramètres qui décrivent topologiquement un pli, et non le système.

Cela a été la grande confusion, née lors de la parution de la théorie de Thom, par son application, surtout à des sciences moins structurées, comme dans les sciences sociales et humaines.

Il s’en est suivi une série d’articles scientifiques dans lesquels chacun trouvait une application de catastrophe à une situation de changement brutal, confondant souvent l’évolution topologique des paramètres avec l’évolution du système. On pourra lire à ce sujet le volume édité par René Thom et Jean Petitot « Logos et Théorie des Catastrophes » (1996, Patino, 515 p.). Il reprend les actes d’un colloque tenu en 1982 au Centre Culturel International de Cerisy. C’était au temps où ce centre organisait des rencontres intéressantes mêlant des sciences humaines et des sciences plus dures, comme la complexité ou la littérature.

C’est alors qu’intervient Sir Erik Christopher Zeeman (1925-2016). C’est un mathématicien anglais connu pour son travail en topologie géométrique et en théorie des singularités. Il a lui aussi participé à l’aventure de l’IHES, puis à « The University of Warwick », à Coventry, où de suite il crée six postes tous en topologie, ce qui permet au département de devenir immédiatement compétitif sur la scène internationale. Deux remarques à ce sujet. L’une est qu’il est capable d'échanger quatre postes académiques contre des subventions. Cela permet à des doctorants de diriger les recherches d'étudiants moins avancés par groupes de deux, d'une façon similaire au système de tutorat pratiqué à Oxford et Cambridge. La seconde est qu’il est anobli en 1991 pour son « excellence mathématique mise au service des mathématiques anglaises et de l'enseignement des mathématiques ». On pourra toujours se consoler en espérant des félicitations de collègues, assorties d’un pot à la charge de l’impétrant.

Christopher Zeeman popularise alors l'idée que la théorie des catastrophes permet de modéliser les situations où des changements progressifs dans les valeurs de paramètres produisent des effets brusques. Cette idée, développée par Stephen Smale, puis par David Ruelle, physicien à l'IHES, consiste à dire que l'approche topologique modifie profondément la manière dont on doit concevoir la modélisation mathématique. Ce qui n’est pas inexact. Elle débouche avec la théorie des systèmes dynamiques et le chaos déterministe. Mais c’est une autre histoire.

Le formalisme de René Thom débouche sur une méthode universelle permettant d'associer une morphologie quelconque à une situation dynamique locale qui l'engendre. Cette relation est indépendante du système, matériel, vivant ou non, qui en est le support. On introduit ainsi la notion de « catastrophe ».

Les applications vont de la physique pure, comme pour les singularités des fronts d’onde en optique, à la morphogenèse en biologie, jusqu’à la théorie des structures syntaxiques en linguistique.

On constate que les conséquences sur la philosophie des sciences vont rapidement bouleverser la façon de considérer les changements brutaux dans l’évolution des systèmes complexes. Avec Smale et Ruelle, on aborde l’aspect, à la fois causal et déterministe des systèmes, ce qui implique la notion d’attracteur, parfois étrange, qui permet d’anticiper l’évolution dynamique d’un système. Ce qui conduit parfois à la notion de chaos. A nouveau, ces concepts ont donné lieu à toute une littérature, souvent à base d’auto-organisation, appelée « Self Organized Criticality » (SOC), qui a pu remplacer la tarte à la crème des Ziegfeld Folies des débuts du cinéma muet. Pour se consoler des catastrophes, on pourra utilement consulter le livre de Pierre Senges « Projectiles au sens propre » (2020, Editions Verticales, 168 p.).

René Thom est un jurassien d’origine, qui passe par l’Ecole Normale Supérieure, avant d’obtenir son doctorat en 1951 à Paris sous la direction, et la canalisation, d’Henri Cartan. Il sera professeur à la Faculté des Sciences de Strasbourg de 1954 à 1963. Recevant une Medal Fields en 1958 sur la topologie différentielle, avant d’intégrer l’« Institut des Hautes Etudes Scientifiques » (IHES) de Bures-sur-Yvette de 1963 à 1990. Il y est en bonne compagnie, puisqu’il y a là Alexandre Grothendieck, puis Pierre Deligne et Alain Connes, tous Medal Fields. C’est vraiment l’âge d’or de ce centre des sciences. Pour ce qui concerne Grothendieck, j’ai récemment relu et commenté les deux tomes de son ouvrage « Récoltes et Semailles » un pavé de 2000 pages (2023, Gallimard, 1506 p.).

Dans « Stabilité structurelle et morphogenèse », René Thom expose sa théorie des catastrophes, en termes simples, avant de diriger le « Séminaire de philosophie et mathématiques », à partir de 1972 à l'ENS. Le but était de confronter les idées sur les rapports entre philosophie et mathématiques. Entre autres, il était également invité d’honneur de l’« Oulipo ».

L’ouvrage est articulé autour de quatre thèmes, mathématique, scientifique au sens large, épistémologique et philosophique.

La partie mathématique est relativement simple à comprendre. Il identifie sept types de catastrophes élémentaires, suivant le nombre de paramètres impliqués, et donc le degré de la courbe qui contrôle le potentiel d’un système. Ce dernier est facile à conceptualiser. Une courbe du second degré (n = 2), par exemple une parabole, admet un seul point minimum. Pour simplifier, on choisira une courbe à concavité vers le bas. Ce point minimum va représenter le point se stabilité du système. Par contre, si on considère une courbe de degré quatre (n = 4), elle possède deux points minimum, séparés par un maximum. Il suffit d’imaginer une bille roulant sur cette courbe. Le maximum est un point instable. Par contre, les deux minima peuvent être considérés comme stables, à condition que l’on ne vienne pas perturber la bille.

Passant de la courbe unidimensionnelle V = f(x) à la surface V = f(x, y), on obtient ainsi les sept formes de « catastrophes » possibles, suivant leur degré et le nombre de paramètres que sont les coefficients des équations, qui contrôlent les minima des courbes. On a ainsi le pli, la plus simple des formes en degré 3 à 1 paramètre. Si deux paramètres existent, et que la courbe est de degré 4, il s’agit d’une fronce. Pour trois paramètres en entrée, et une variable, il s’agit de la queue d’aronde. Pour deux variables, c’est un ombilic hyperbolique (vague) ou elliptique (poil) selon son comportement à l’infini. Enfin, pour quatre paramètres on aura un papillon si c’est une courbe, à une variable ou un champignon, ombilic parabolique si c’est une surface. Avec plus de paramètres, d’autres formes de catastrophes distinctes apparaissent.

On constate donc de suite que le nombre de variables (x) ou (x, y) va déterminer si c’est une courbe ou une surface. Par contre, le nombre de paramètres joue sur le nombre et position des points d’équilibre ou d’instabilité, suivant la concavité des courbes.

Et c’est là que tout est parti en catastrophe, c’est le cas de le dire. La théorie de René Thom est essentiellement une description mathématique d’un passage entre deux situations, c’est la description d‘une bifurcation dynamique. Le système passe brutalement d’un état à un autre, c’et la notion de catastrophe. Par contre, dire que c’est un pli, une fronce ou un papillon, n’a aucun rapport avec l’évolution des paramètres. Ou du moins leur mode d’évolution. Un pli, par exemple, n’implique pas que le système se replie sur lui-même. Ce sont les paramètres qui décrivent topologiquement un pli, et non le système.

Cela a été la grande confusion, née lors de la parution de la théorie de Thom, par son application, surtout à des sciences moins structurées, comme dans les sciences sociales et humaines.

Il s’en est suivi une série d’articles scientifiques dans lesquels chacun trouvait une application de catastrophe à une situation de changement brutal, confondant souvent l’évolution topologique des paramètres avec l’évolution du système. On pourra lire à ce sujet le volume édité par René Thom et Jean Petitot « Logos et Théorie des Catastrophes » (1996, Patino, 515 p.). Il reprend les actes d’un colloque tenu en 1982 au Centre Culturel International de Cerisy. C’était au temps où ce centre organisait des rencontres intéressantes mêlant des sciences humaines et des sciences plus dures, comme la complexité ou la littérature.

C’est alors qu’intervient Sir Erik Christopher Zeeman (1925-2016). C’est un mathématicien anglais connu pour son travail en topologie géométrique et en théorie des singularités. Il a lui aussi participé à l’aventure de l’IHES, puis à « The University of Warwick », à Coventry, où de suite il crée six postes tous en topologie, ce qui permet au département de devenir immédiatement compétitif sur la scène internationale. Deux remarques à ce sujet. L’une est qu’il est capable d'échanger quatre postes académiques contre des subventions. Cela permet à des doctorants de diriger les recherches d'étudiants moins avancés par groupes de deux, d'une façon similaire au système de tutorat pratiqué à Oxford et Cambridge. La seconde est qu’il est anobli en 1991 pour son « excellence mathématique mise au service des mathématiques anglaises et de l'enseignement des mathématiques ». On pourra toujours se consoler en espérant des félicitations de collègues, assorties d’un pot à la charge de l’impétrant.

Christopher Zeeman popularise alors l'idée que la théorie des catastrophes permet de modéliser les situations où des changements progressifs dans les valeurs de paramètres produisent des effets brusques. Cette idée, développée par Stephen Smale, puis par David Ruelle, physicien à l'IHES, consiste à dire que l'approche topologique modifie profondément la manière dont on doit concevoir la modélisation mathématique. Ce qui n’est pas inexact. Elle débouche avec la théorie des systèmes dynamiques et le chaos déterministe. Mais c’est une autre histoire.

Le formalisme de René Thom débouche sur une méthode universelle permettant d'associer une morphologie quelconque à une situation dynamique locale qui l'engendre. Cette relation est indépendante du système, matériel, vivant ou non, qui en est le support. On introduit ainsi la notion de « catastrophe ».

Les applications vont de la physique pure, comme pour les singularités des fronts d’onde en optique, à la morphogenèse en biologie, jusqu’à la théorie des structures syntaxiques en linguistique.

On constate que les conséquences sur la philosophie des sciences vont rapidement bouleverser la façon de considérer les changements brutaux dans l’évolution des systèmes complexes. Avec Smale et Ruelle, on aborde l’aspect, à la fois causal et déterministe des systèmes, ce qui implique la notion d’attracteur, parfois étrange, qui permet d’anticiper l’évolution dynamique d’un système. Ce qui conduit parfois à la notion de chaos. A nouveau, ces concepts ont donné lieu à toute une littérature, souvent à base d’auto-organisation, appelée « Self Organized Criticality » (SOC), qui a pu remplacer la tarte à la crème des Ziegfeld Folies des débuts du cinéma muet. Pour se consoler des catastrophes, on pourra utilement consulter le livre de Pierre Senges « Projectiles au sens propre » (2020, Editions Verticales, 168 p.).

Rien capté.

« Prédire n'est pas expliquer » (1999, Flammarion, 175 p.) du mathématicien français René Thom, célèbre pour sa « Théorie des Catastrophes », et par ailleurs Medal Fields en 1958.

René Thom (1923-2002), natif de Montbéliard est donc jurassien d’origine. Je réactualise ces fiches de lecture à l’occasion du centenaire de sa naissance. Il passe par l’Ecole Normale Supérieure, avant d’obtenir son doctorat en 1951 à Paris sous la direction d’Henri Cartan, l’un des fondateurs du groupe Bourbaki, avant d’être nommé professeur à la Faculté des Sciences de Strasbourg de 1954 à 1963. Recevant le prix Medal Fields en 1958 pour ses travaux sur la topologie différentielle, il intègre l’« Institut des Hautes Etudes Scientifiques » (IHES) de Bures-sur-Yvette de 1963 à 1990. Il y est en bonne compagnie, puisqu’il y a là Alexandre Grothendieck, puis Pierre Deligne et Alain Connes, tous Medal Fields. C’est vraiment l’âge d’or de ce centre des sciences. Pour ce qui concerne Grothendieck, j’ai récemment relu et commenté les deux tomes de son ouvrage « Récoltes et Semailles » un pavé de 2000 pages (2023, Gallimard, 1506 p.).

L’ouvrage de René Thom qui le fait connaitre « Stabilité structurelle et morphogenèse » est le premier, je crois, destiné au grand public sur la théorie des catastrophes (1977, Interéditions, 382 p.). Il sera suivi de « Modèles Mathématiques de la Morphogénèse » (1980, Christian Bourgois, 320 p.). En 2003 un CD-ROM a été édité par l’IHES qui regroupe ses œuvres complètes.

Dès le début, la théorie des catastrophes rencontre un succès qui est plus que de l’estime. Le mathématicien Jean-Pierre Bourguignon, directeur de l’IHES à l’époque témoigne « La théorie des catastrophes était devenue le nec plus ultra, il n'y avait rien de plus « in » ». Il faut dire que le nom était compréhensible par tous, plus facile à retenir que topologie différentielle ou application différentiable entre variétés différentielles. Du point de vue application, pas de problème non plus, la théorie s’appliquait à tout. Enfin, René Thom a su donner à ses catégories de catastrophes des noms poétiques, tels que le pli, la queue d'aronde, la fronce, le papillon, et la famille de l'ombilic, elliptique, parabolique et hyperbolique.

Tout allait bien, jusque vers 1976, lorsque ses opposants se réveillent. On reproche surtout à la théorie de ne pas être prédictive. Et de fait, c’est une classification, et de plus, ces catégories sont essentiellement qualitatives, et non pas quantitatives. Et ces formes s’adressent aux paramètres, et non pas aux systèmes. D’où le titre du présent ouvrage « Prédire n'est pas expliquer ».

Ce livre résulte d’une série d'entretiens avec Émile Noël. Il met en évidence la passion de toute une vie pour René Thom. Expliquer, faire reculer les frontières de l'intelligible. Comment devient-on mathématicien ? L'ouvrage expose alors la genèse de la théorie des catastrophes, les polémiques qu'elle a suscitées et les positions philosophiques et épistémologiques de René Thom. Il suggère qu’à côté de la science quantitative et prédictive, il existe une approche qualitative dont la valeur explicative est peut-être plus décisive pour la connaissance. S’ensuivent des positions philosophiques sur « le distinct et le continu », puis sur la science en général avec le rapport entre qualitatif et quantitatif. Cette démarche scientifique est extrêmement originale.

A la fin de « Prédire n'est pas expliquer », il y a un croquis de la main de René Thom un peu analogue à la « Carte du Tendre ». Ce pays est situé entre « La Mer de l’Insignifiance » et « L’Altiplano de l’Absurde », encadré par « La Colline des Métaphores » et « Le Massif de la Réalité ». Aussi surprenant soit-il, on y trouve « La Cité des Sciences Humaines et des Arts », bien déparée des « Sciences Expérimentales » et de la « Biologie », toutes deux au pied du « Temple des Mathématiques ».

La théorie des catastrophes ne propose aucune mesure quantitative des manifestations du monde extérieur, et donc à aucune prédiction. Par contre, elle tend à l’expliquer et ainsi à fournir une « Théorie générale de l’intelligibilité ». Par là, René Thom suggère « une théorie de la signification, dont la nature soit telle que l’acte même de connaître soit une conséquence de la théorie ». C’est ainsi qu’il définit sa vision du monde. C’est aussi le principal reproche que ses détracteurs ont pu lui adresser. Non prédictive, sa théorie n’aurait aucune valeur ou importance. Avec cette conséquence que c’est aussi valable pour la théorie de l’évolution de Darwin. Peut-on déduire la carrière prodigieuse d’un Picasso, d’un esclave noir ou d’un doyen de l’humanité, à partir de la bactérie.

Décrire, comprendre et expliquer sont des notions relativement simples en sciences. Quelquefois le dernier terme « expliquer » est remplacé par « compliquer », car il est plus facile de plaquer un jargon spécifique sur une chose que l’on appréhende mal.

Décrire et comprendre font l’objet de la construction d’un modèle, censé expliquer les causes et conséquences des observations. Cette construction s’effectue de deux façons différentes, elles même divisées en problèmes direct ou inverse

Dans un cas, on part d’un certain nombre d’observations et on essaye de déterminer quelles en sont les causes est souvent décrite comme de bas vers le haut (bottom-up). Par opposition une autre catégorie de modèles procède de manière inverse. Il s’agit de déterminer l’influence de tel paramètre, avec production de telle cause. On procède alors de haut vers le bas (top-down). Souvent le problème est plus complexe et la simulation sert alors à hiérarchiser les effets causés par les différentes causes.

Enfin une dernière catégorie de modèles est récemment apparue qui aboutit à une auto-organisation des phénomènes, sans que l’on sache exactement pour l’instant ce qui la provoque (si ce n’est une complexité des rétroactions). Cela aboutit à ce que l’on nomme les réseaux neuronaux, avec de multiples développements dans la recherche de l’auto apprentissage (deep learning) ou de l’intelligence artificielle (IA). Mais l’un n’explique pas l’autre. Le retour à l’expérimentation et surtout la démonstration de la reproductibilité des résultats limite sérieusement la modélisation.

En fait cette classification en top-down et bottom-up peut aussi se résumer en modèlisation directe et inverse, le sens (la direction) étant des données aux causes. Le problème de la sous détermination, c'est-à-dire du nombre des observations (des équations) par rapport aux inconnues, reste identique. Tout comme la linéarité (ou non) des relations. Certes, la solution à la non-linéarité se traduit souvent par une pseudo-linéarisation. C’est le cas le plus fréquent lors de la méthode la plus utilisée, celle de l’approximation des moindres carrés. C’est ce qui est utilisé le plus souvent lors des approximations de droite dans un nuage de points dans des tableurs communs. Mais on constate que cela reste une approximation. Deux grands facteurs d’incertitude sont inhérents à ces systèmes d’équations. Ils sont liés aux valeurs et vecteurs propres, en d’autres termes ce sont les « solutions principales ». D’une part, la différence de grandeurs entre ces valeurs propres, soit leur poids respectif, influe grandement sur les solutions. De l’autre, le poids relatif des faibles valeurs propres reflète le plus souvent une redondance, c'est-à-dire une sorte de valeur ajoutée quasi nulle. Il est notable qu’augmenter le nombre de mesures, c’est-à-dire d’équations, conduit souvent à accroitre le nombre de ces valeurs propres à faible valeur ajoutée, donc cela est inutile.

Les conséquences de ces modélisations s’expriment spécialement sur le nombre et qualité des solutions offertes. En termes savants, cela s’appelle la sur- et la sous-détermination. Cette distinction est la plus souvent omise par les modélisateurs. Elle est pourtant fondamentale. Dans la modélisation par problème direct, on part des propriétés physiques du modèle, soit sa forme, volume, densité, autres propriétés. On part également d’une équation qui est censée relier ces propriétés aux mesures. Ensuite, par variations sensibles des paramètres, on essaye d’obtenir des valeurs proches des mesures.

A l’opposé, dans le problème inverse, on part des mesures et par des méthodes numériques complexes, on essaye de retrouver les paramètres qui donnent les résultats les plus proches des mesures. Du point de vue mathématique, le premier cas donne toujours une solution. On dit que le problème est surdimensionné. Pas contre, il est sous-dimensionné dans le second cas, et l’on a affaire à une série de valeurs « probables, ou pas trop mauvaises ». Un second critère, généralement statistique est alors nécessaire pour sélectionner les « bons paramètres ».

Tous les modélisateurs devraient lire « Qu'est-ce qu'un Modèle ? » de Henri Atlan (11, Editions Manucius, 48 p.). La réponse d’Atlan, qui a été président du Comité d’Ethique, avant de poursuivre des études du Talmud et de soutenir une thèse en Sorbonne sur Spinoza, tient en environ 25 pages de petit format (10*14.5 cm) et quelques 100 000 signes. Il est assez amusant que ce texte ait donné lieu à des discussions presque plus longues, certaines ayant un fond de vérité, d’autres étant plutôt des justifications de modélisateurs qui défendaient leur bonne foi (et leurs travaux). C’est aussi une bonne raison de (re)lire Baruch Spinoza (1632-1677). Cela d’autant plus que vient de sortir un livre de Henri Atlan « Cours de philosophie biologique et cognitive, Spinoza et la biologie actuelle » (2018, Odile Jacob, 636 p.).

A ce stade, on a décrit, en partie compris. Il reste à prédire, ce qui n’est pas gagné d’avance. Examinant les catastrophes naturelles, telles que séismes, éruptions volcaniques, tsunamis, la science a vite trouvé son maitre. Tous ces évènements procèdent de phénomènes aléatoires, agissent en termes de vulnérabilité et induisent donc des risques. Une des rares chose que l’on peut leur opposer c’est une préparation antérieure, une prévention des risques. Il convient de séparer les notions d’aléas et de vulnérabilité. Un séisme, par exemple, qui est un aléa, est relativement imprédictible dans le temps. Par contre, il n’aura pas le même effet, sa vulnérabilité, s’il se produit dans une région fortement urbanisée, et donc peuplée, ou au milieu d’un désert, vide ou très peu peuplé. Reste la prévention, qui consiste à prendre des mesures sécuritaires pour réduire les dégâts, préparer les populations et les secours. En d’autres termes, faire en sorte que le risque soit moindre.

En ce sens la théorie des catastrophes est une avancée. Certes, elle ne permet pas de prédire ou prévoir. Ce n’était d’ailleurs pas le but de René Thom. « Si l’on n’a pas le concept d’un objet, on ne le reconnaîtra pas ». Il propose donc que sa théorie puisse fournir des analogies. « Cette théorie a pour intérêt principal de proposer une théorie mathématique de l’analogie ». Cette analogie n’est pas simplement ne juxtaposition, un peu comme une carpe et un lapin, ou un cheval et une alouette pour en faire un pâté. « L’analogie, la métaphore, contrairement à la vision commune qui en fait quelque chose d’approximatif, de flou, m’apparaît comme une relation stricte et que l’on peut, dans bien des cas, exprimer mathématiquement ».

« La théorie des catastrophes est plutôt une méthodologie qui permet de comprendre, dans beaucoup de cas, et de modéliser dans un certain nombre de cas, des situations qui, autrement, seraient très difficiles à atteindre, des systèmes dont on ne pourrait pas obtenir une description parce qu’ils sont trop compliqués, qu’ils possèdent trop d’éléments ». Il est vrai qu’avec cette approche des phénomènes naturels, il est extrêmement difficile de cerner les véritables paramètres, et surtout leurs interactions, qui les génèrent. « Peu de phénomènes dans la nature sont régis par des lois quantitatives exactes et précises. Par définition, c’est le domaine de la physique, pourrait-on dire. Toutes les autres lois sont approchées ».

Avec son aisance habituelle, il prend un exemple simple. « La manche de ma veste, si je la comprime, je fais apparaître des plis. C’est une situation générale. Cela ne relève pas de la mécanique des matériaux ». On aura compris, ce qu’il explicite mathématiquement ensuite, que « lorsqu’un espace est soumis à une contrainte, c’est-à-dire lorsqu’on le projette sur quelque chose de plus petit que sa propre dimension, il accepte la contrainte, sauf en un certain nombre de points où il concentre, si l’on peut dire, toute son individualité première. Et c’est dans la présence de ces singularités que se fait la résistance ».

J’en reviens à ce que j’ai déjà écrit à propos de la théorie des catastrophes, c’est une description, une topologie, des paramètres qui génèrent une discontinuité, et non une quelconque géométrie de cette discontinuité. « Ce qu’offre la théorie des catastrophes, surtout des catastrophes élémentaires, c’est la description de conflits de tendances ».

La distinction que René Thom avance entre le discret et le continu n’est pas anodine. Elle est liée à l’IHES et aux travaux qui s’y déroulent, notamment ceux de Alexandre Grothendieck. Ce dernier va refuser les prestigieux Medal Fields en 1977 et Prix Crafoord en 1988, équivalent du Nobel en mathématiques. Il propose donc de développer une « géométrie algébrique », réunification de deux mondes jadis séparés. Naturellement ce n’est pas si simple, il faut introduire de nouveaux concepts et outils. Ce seront les notions de schéma et celle de topos, auxquelles il faut ajouter les faisceaux qui révolutionne la notion d’espace, formant une infinité de théories cohomologiques, dont se dégage la notion de motif. Très abstrait, et leur définition strictement mathématique n’aide pas à la compréhension. D’autant que ce vocabulaire nouveau est adopté d’un schéma ancien, ce qui embrouille encore plus le non-spécialiste. « Par là, elle est apte à saisir les structures et phénomènes continus : les mouvements, espaces, comme la science des structures discrètes, et l’analyse, comme la science des structures continues ». Ces notions de continu et de discontinu sont par la suite essentielles et définissent l’arithmétique et la géométrie.

« Ce qui limite le vrai, ce n’est pas le faux, c’est l’insignifiant ».

René Thom (1923-2002), natif de Montbéliard est donc jurassien d’origine. Je réactualise ces fiches de lecture à l’occasion du centenaire de sa naissance. Il passe par l’Ecole Normale Supérieure, avant d’obtenir son doctorat en 1951 à Paris sous la direction d’Henri Cartan, l’un des fondateurs du groupe Bourbaki, avant d’être nommé professeur à la Faculté des Sciences de Strasbourg de 1954 à 1963. Recevant le prix Medal Fields en 1958 pour ses travaux sur la topologie différentielle, il intègre l’« Institut des Hautes Etudes Scientifiques » (IHES) de Bures-sur-Yvette de 1963 à 1990. Il y est en bonne compagnie, puisqu’il y a là Alexandre Grothendieck, puis Pierre Deligne et Alain Connes, tous Medal Fields. C’est vraiment l’âge d’or de ce centre des sciences. Pour ce qui concerne Grothendieck, j’ai récemment relu et commenté les deux tomes de son ouvrage « Récoltes et Semailles » un pavé de 2000 pages (2023, Gallimard, 1506 p.).

L’ouvrage de René Thom qui le fait connaitre « Stabilité structurelle et morphogenèse » est le premier, je crois, destiné au grand public sur la théorie des catastrophes (1977, Interéditions, 382 p.). Il sera suivi de « Modèles Mathématiques de la Morphogénèse » (1980, Christian Bourgois, 320 p.). En 2003 un CD-ROM a été édité par l’IHES qui regroupe ses œuvres complètes.

Dès le début, la théorie des catastrophes rencontre un succès qui est plus que de l’estime. Le mathématicien Jean-Pierre Bourguignon, directeur de l’IHES à l’époque témoigne « La théorie des catastrophes était devenue le nec plus ultra, il n'y avait rien de plus « in » ». Il faut dire que le nom était compréhensible par tous, plus facile à retenir que topologie différentielle ou application différentiable entre variétés différentielles. Du point de vue application, pas de problème non plus, la théorie s’appliquait à tout. Enfin, René Thom a su donner à ses catégories de catastrophes des noms poétiques, tels que le pli, la queue d'aronde, la fronce, le papillon, et la famille de l'ombilic, elliptique, parabolique et hyperbolique.

Tout allait bien, jusque vers 1976, lorsque ses opposants se réveillent. On reproche surtout à la théorie de ne pas être prédictive. Et de fait, c’est une classification, et de plus, ces catégories sont essentiellement qualitatives, et non pas quantitatives. Et ces formes s’adressent aux paramètres, et non pas aux systèmes. D’où le titre du présent ouvrage « Prédire n'est pas expliquer ».

Ce livre résulte d’une série d'entretiens avec Émile Noël. Il met en évidence la passion de toute une vie pour René Thom. Expliquer, faire reculer les frontières de l'intelligible. Comment devient-on mathématicien ? L'ouvrage expose alors la genèse de la théorie des catastrophes, les polémiques qu'elle a suscitées et les positions philosophiques et épistémologiques de René Thom. Il suggère qu’à côté de la science quantitative et prédictive, il existe une approche qualitative dont la valeur explicative est peut-être plus décisive pour la connaissance. S’ensuivent des positions philosophiques sur « le distinct et le continu », puis sur la science en général avec le rapport entre qualitatif et quantitatif. Cette démarche scientifique est extrêmement originale.

A la fin de « Prédire n'est pas expliquer », il y a un croquis de la main de René Thom un peu analogue à la « Carte du Tendre ». Ce pays est situé entre « La Mer de l’Insignifiance » et « L’Altiplano de l’Absurde », encadré par « La Colline des Métaphores » et « Le Massif de la Réalité ». Aussi surprenant soit-il, on y trouve « La Cité des Sciences Humaines et des Arts », bien déparée des « Sciences Expérimentales » et de la « Biologie », toutes deux au pied du « Temple des Mathématiques ».

La théorie des catastrophes ne propose aucune mesure quantitative des manifestations du monde extérieur, et donc à aucune prédiction. Par contre, elle tend à l’expliquer et ainsi à fournir une « Théorie générale de l’intelligibilité ». Par là, René Thom suggère « une théorie de la signification, dont la nature soit telle que l’acte même de connaître soit une conséquence de la théorie ». C’est ainsi qu’il définit sa vision du monde. C’est aussi le principal reproche que ses détracteurs ont pu lui adresser. Non prédictive, sa théorie n’aurait aucune valeur ou importance. Avec cette conséquence que c’est aussi valable pour la théorie de l’évolution de Darwin. Peut-on déduire la carrière prodigieuse d’un Picasso, d’un esclave noir ou d’un doyen de l’humanité, à partir de la bactérie.

Décrire, comprendre et expliquer sont des notions relativement simples en sciences. Quelquefois le dernier terme « expliquer » est remplacé par « compliquer », car il est plus facile de plaquer un jargon spécifique sur une chose que l’on appréhende mal.

Décrire et comprendre font l’objet de la construction d’un modèle, censé expliquer les causes et conséquences des observations. Cette construction s’effectue de deux façons différentes, elles même divisées en problèmes direct ou inverse

Dans un cas, on part d’un certain nombre d’observations et on essaye de déterminer quelles en sont les causes est souvent décrite comme de bas vers le haut (bottom-up). Par opposition une autre catégorie de modèles procède de manière inverse. Il s’agit de déterminer l’influence de tel paramètre, avec production de telle cause. On procède alors de haut vers le bas (top-down). Souvent le problème est plus complexe et la simulation sert alors à hiérarchiser les effets causés par les différentes causes.

Enfin une dernière catégorie de modèles est récemment apparue qui aboutit à une auto-organisation des phénomènes, sans que l’on sache exactement pour l’instant ce qui la provoque (si ce n’est une complexité des rétroactions). Cela aboutit à ce que l’on nomme les réseaux neuronaux, avec de multiples développements dans la recherche de l’auto apprentissage (deep learning) ou de l’intelligence artificielle (IA). Mais l’un n’explique pas l’autre. Le retour à l’expérimentation et surtout la démonstration de la reproductibilité des résultats limite sérieusement la modélisation.

En fait cette classification en top-down et bottom-up peut aussi se résumer en modèlisation directe et inverse, le sens (la direction) étant des données aux causes. Le problème de la sous détermination, c'est-à-dire du nombre des observations (des équations) par rapport aux inconnues, reste identique. Tout comme la linéarité (ou non) des relations. Certes, la solution à la non-linéarité se traduit souvent par une pseudo-linéarisation. C’est le cas le plus fréquent lors de la méthode la plus utilisée, celle de l’approximation des moindres carrés. C’est ce qui est utilisé le plus souvent lors des approximations de droite dans un nuage de points dans des tableurs communs. Mais on constate que cela reste une approximation. Deux grands facteurs d’incertitude sont inhérents à ces systèmes d’équations. Ils sont liés aux valeurs et vecteurs propres, en d’autres termes ce sont les « solutions principales ». D’une part, la différence de grandeurs entre ces valeurs propres, soit leur poids respectif, influe grandement sur les solutions. De l’autre, le poids relatif des faibles valeurs propres reflète le plus souvent une redondance, c'est-à-dire une sorte de valeur ajoutée quasi nulle. Il est notable qu’augmenter le nombre de mesures, c’est-à-dire d’équations, conduit souvent à accroitre le nombre de ces valeurs propres à faible valeur ajoutée, donc cela est inutile.

Les conséquences de ces modélisations s’expriment spécialement sur le nombre et qualité des solutions offertes. En termes savants, cela s’appelle la sur- et la sous-détermination. Cette distinction est la plus souvent omise par les modélisateurs. Elle est pourtant fondamentale. Dans la modélisation par problème direct, on part des propriétés physiques du modèle, soit sa forme, volume, densité, autres propriétés. On part également d’une équation qui est censée relier ces propriétés aux mesures. Ensuite, par variations sensibles des paramètres, on essaye d’obtenir des valeurs proches des mesures.

A l’opposé, dans le problème inverse, on part des mesures et par des méthodes numériques complexes, on essaye de retrouver les paramètres qui donnent les résultats les plus proches des mesures. Du point de vue mathématique, le premier cas donne toujours une solution. On dit que le problème est surdimensionné. Pas contre, il est sous-dimensionné dans le second cas, et l’on a affaire à une série de valeurs « probables, ou pas trop mauvaises ». Un second critère, généralement statistique est alors nécessaire pour sélectionner les « bons paramètres ».

Tous les modélisateurs devraient lire « Qu'est-ce qu'un Modèle ? » de Henri Atlan (11, Editions Manucius, 48 p.). La réponse d’Atlan, qui a été président du Comité d’Ethique, avant de poursuivre des études du Talmud et de soutenir une thèse en Sorbonne sur Spinoza, tient en environ 25 pages de petit format (10*14.5 cm) et quelques 100 000 signes. Il est assez amusant que ce texte ait donné lieu à des discussions presque plus longues, certaines ayant un fond de vérité, d’autres étant plutôt des justifications de modélisateurs qui défendaient leur bonne foi (et leurs travaux). C’est aussi une bonne raison de (re)lire Baruch Spinoza (1632-1677). Cela d’autant plus que vient de sortir un livre de Henri Atlan « Cours de philosophie biologique et cognitive, Spinoza et la biologie actuelle » (2018, Odile Jacob, 636 p.).

A ce stade, on a décrit, en partie compris. Il reste à prédire, ce qui n’est pas gagné d’avance. Examinant les catastrophes naturelles, telles que séismes, éruptions volcaniques, tsunamis, la science a vite trouvé son maitre. Tous ces évènements procèdent de phénomènes aléatoires, agissent en termes de vulnérabilité et induisent donc des risques. Une des rares chose que l’on peut leur opposer c’est une préparation antérieure, une prévention des risques. Il convient de séparer les notions d’aléas et de vulnérabilité. Un séisme, par exemple, qui est un aléa, est relativement imprédictible dans le temps. Par contre, il n’aura pas le même effet, sa vulnérabilité, s’il se produit dans une région fortement urbanisée, et donc peuplée, ou au milieu d’un désert, vide ou très peu peuplé. Reste la prévention, qui consiste à prendre des mesures sécuritaires pour réduire les dégâts, préparer les populations et les secours. En d’autres termes, faire en sorte que le risque soit moindre.

En ce sens la théorie des catastrophes est une avancée. Certes, elle ne permet pas de prédire ou prévoir. Ce n’était d’ailleurs pas le but de René Thom. « Si l’on n’a pas le concept d’un objet, on ne le reconnaîtra pas ». Il propose donc que sa théorie puisse fournir des analogies. « Cette théorie a pour intérêt principal de proposer une théorie mathématique de l’analogie ». Cette analogie n’est pas simplement ne juxtaposition, un peu comme une carpe et un lapin, ou un cheval et une alouette pour en faire un pâté. « L’analogie, la métaphore, contrairement à la vision commune qui en fait quelque chose d’approximatif, de flou, m’apparaît comme une relation stricte et que l’on peut, dans bien des cas, exprimer mathématiquement ».

« La théorie des catastrophes est plutôt une méthodologie qui permet de comprendre, dans beaucoup de cas, et de modéliser dans un certain nombre de cas, des situations qui, autrement, seraient très difficiles à atteindre, des systèmes dont on ne pourrait pas obtenir une description parce qu’ils sont trop compliqués, qu’ils possèdent trop d’éléments ». Il est vrai qu’avec cette approche des phénomènes naturels, il est extrêmement difficile de cerner les véritables paramètres, et surtout leurs interactions, qui les génèrent. « Peu de phénomènes dans la nature sont régis par des lois quantitatives exactes et précises. Par définition, c’est le domaine de la physique, pourrait-on dire. Toutes les autres lois sont approchées ».

Avec son aisance habituelle, il prend un exemple simple. « La manche de ma veste, si je la comprime, je fais apparaître des plis. C’est une situation générale. Cela ne relève pas de la mécanique des matériaux ». On aura compris, ce qu’il explicite mathématiquement ensuite, que « lorsqu’un espace est soumis à une contrainte, c’est-à-dire lorsqu’on le projette sur quelque chose de plus petit que sa propre dimension, il accepte la contrainte, sauf en un certain nombre de points où il concentre, si l’on peut dire, toute son individualité première. Et c’est dans la présence de ces singularités que se fait la résistance ».

J’en reviens à ce que j’ai déjà écrit à propos de la théorie des catastrophes, c’est une description, une topologie, des paramètres qui génèrent une discontinuité, et non une quelconque géométrie de cette discontinuité. « Ce qu’offre la théorie des catastrophes, surtout des catastrophes élémentaires, c’est la description de conflits de tendances ».

La distinction que René Thom avance entre le discret et le continu n’est pas anodine. Elle est liée à l’IHES et aux travaux qui s’y déroulent, notamment ceux de Alexandre Grothendieck. Ce dernier va refuser les prestigieux Medal Fields en 1977 et Prix Crafoord en 1988, équivalent du Nobel en mathématiques. Il propose donc de développer une « géométrie algébrique », réunification de deux mondes jadis séparés. Naturellement ce n’est pas si simple, il faut introduire de nouveaux concepts et outils. Ce seront les notions de schéma et celle de topos, auxquelles il faut ajouter les faisceaux qui révolutionne la notion d’espace, formant une infinité de théories cohomologiques, dont se dégage la notion de motif. Très abstrait, et leur définition strictement mathématique n’aide pas à la compréhension. D’autant que ce vocabulaire nouveau est adopté d’un schéma ancien, ce qui embrouille encore plus le non-spécialiste. « Par là, elle est apte à saisir les structures et phénomènes continus : les mouvements, espaces, comme la science des structures discrètes, et l’analyse, comme la science des structures continues ». Ces notions de continu et de discontinu sont par la suite essentielles et définissent l’arithmétique et la géométrie.

« Ce qui limite le vrai, ce n’est pas le faux, c’est l’insignifiant ».

« Modèles Mathématiques de la Morphogénèse » du mathématicien français René Thom (1980, Christian Bourgois, 320 p.).

René Thom (1923-2002) est un jurassien d’origine, de Montbéliard en particulier, qui passe par l’Ecole Normale Supérieure, avant d’obtenir son doctorat en 1951 à Paris sous la direction, et la canalisation, d’Henri Cartan. Il sera professeur à la Faculté des Sciences de Strasbourg de 1954 à 1963. Recevant un prix Medal Fields en 1958 sur la topologie différentielle, avant d’intégrer l’« Institut des Hautes Etudes Scientifiques » (IHES) de Bures-sur-Yvette de 1963 à 1990. Il y est en bonne compagnie, puisqu’il y a là Alexandre Grothendieck, puis Pierre Deligne et Alain Connes, tous Medal Fields. C’est vraiment l’âge d’or de ce centre des sciences. Pour ce qui concerne Grothendieck, j’ai récemment relu et commenté les deux tomes de son ouvrage « Récoltes et Semailles » un pavé de 2000 pages (2023, Gallimard, 1506 p.). A vrai dire, je profite du centenaire de sa naissance pour réactualiser ces fiches de lecture.

Son premier ouvrage « Stabilité structurelle et morphogenèse » est le premier, je crois, destiné au grand public sur la théorie des catastrophes (1977, Interéditions, 382 p.). Il a été réédité plusieurs fois par la suite.

L’ouvrage actuel fournit des modèles d'explications scientifiques de la théorie des catastrophes. Il aborde les questions de sémantique, ou plus simplement la signification des signes, spécifiquement dans le langage. Tout cela à partir de problèmes de topologie. L’intérêt de l’ouvrage est de présenter une étude précise et très documentée sur la réalité et les limites de l'utilisation de ces concepts. « L’idée essentielle de notre théorie, à savoir qu’une certaine compréhension des processus morphogénétiques est possible sans avoir recours aux propriétés spéciales au substrat des formes, ou à la nature des forces agissantes, pourra sembler difficile à admettre, surtout de la part d’expérimentateurs habitués à tailler dans le vif, et continuellement en lutte avec une réalité qui leur résiste ».

L’idée part en partie d’un ouvrage de Alan Turing intitulé « The Chemical Basis of Morphogenesis » publié dans « Philosophical Transactions of the Royal Society B Biological Sciences » (1952, Phil. Trans. Royal Soc. B237, 37-72). C’est le A.M. Turing (1912-1954) mathématicien britannique, auteur de travaux qui fondent scientifiquement la cryptographie. C’est aussi un des pionniers de l'Intelligence artificielle. Il se suicide en 1954 pour éviter d’être poursuivi pour homosexualité. Ila cependant été anobli par la reine.

Dans cet article, Turing décrit comment des motifs peuvent apparaitre dans la nature à partir d’un état homogène et uniforme ? Ces motifs (patterns) incluent des rayures et des spirales, comme les raies du zèbre. Cela suppose des réactions chimiques appelées de « réaction-diffusion ». On pourra lire à ce sujet l’épais ouvrage de James D Murray « Mathematical Biology » (2007, Springer, 781 p.) qui explique pourquoi la moufette a un corps noir avec une queue et un dos blanc. Le même bicolorisme était observé chez le ramoneur savoyard, mais la différence résidait surtout en ce qu’il portait souvent une petite échelle.

Cette physico-chimie de réaction-diffusion est basée sur une interaction entre la diffusion d’un pigment et le taux de réaction chimique, et quoiqu’elle s’applique facilement à des géométries simples, elle est plus complexe à simuler des patterns irréguliers. C’est là que la théorie de la morphogenèse de René Thom intervient. « La science naît du jour où des erreurs, des échecs, des surprises désagréables, nous poussent à regarder le réel de plus près ».

Le traitement mathématique de ce problème s’applique à de nombreux autres domaines comme l’hydrodynamique, la cristallographie, la géophysique, ou la dynamique des populations, pour n’en citer que ces exemples. Cela reflète l’existence de « classes d’universalité » des formes et de leur apparition dans les systèmes naturels.

Cependant, certaines formes, comme la structure alvéolaire de la cire d’abeille dans les ruches, procède de raisons différentes. En effet, dans ce cas, la structure hexagonale est celle qui nécessite le moins de cire pour produire le maximum d’espace libre. Il suffit de calculer les périmètres respectifs des triangles, carrés et hexagones et de constater que les abeilles construisent à l’économie.

René Thom identifie et individualise différents types de catastrophes élémentaires, suivant le nombre de paramètres impliqués, et selon le degré de la courbe qui contrôle le potentiel d’un système. Ce dernier est facile à conceptualiser. Une courbe du second degré (n = 2), par exemple une parabole, admet un seul point minimum ou maximum, selon sa concavité. Pour simplifier, on choisira une courbe à concavité vers le bas. Ce point minimum va représenter le point se stabilité du système. Par contre, si on considère une courbe de degré quatre (n = 4), elle possède deux points minimum, séparés par un maximum. Il faut imaginer une bille roulant sur cette courbe. Le maximum est un point instable. Par contre, les deux minima peuvent être considérés comme stables, à condition que l’on ne vienne pas perturber la bille.

Passant de la courbe unidimensionnelle V = f(x) à la surface V = f(x, y), on obtient ainsi les sept formes de « catastrophes » possibles, suivant leur degré et le nombre de paramètres que sont les coefficients des équations, qui contrôlent les minima des courbes. On a ainsi le pli, la plus simple des formes en degré 3 à un seul paramètre. Si deux paramètres existent, et que la courbe est de degré 4, il s’agit d’une fronce. Pour trois paramètres en entrée, et une variable, il s’agit de la queue d’aronde. Pour deux variables, c’est un ombilic hyperbolique (vague) ou elliptique (poil) selon son comportement à l’infini. Enfin, pour quatre paramètres on aura un papillon si c’est une courbe, à une variable ou un champignon, ombilic parabolique si c’est une surface. Avec plus de paramètres, d’autres formes de catastrophes distinctes apparaissent.

On constate donc de suite que le nombre de variables (x) ou (x, y) va déterminer si c’est une courbe ou une surface. Par contre, le nombre de paramètres joue sur le nombre et la position des points d’équilibre ou d’instabilité, suivant la concavité des courbes.

Et c’est là que tout est parti en catastrophe, c’est le cas de le dire. La théorie de René Thom est essentiellement une description mathématique d’un passage entre deux situations, c’est la description d‘une bifurcation dynamique. Le système passe brutalement d’un état à un autre, c’est la notion de catastrophe. Par contre, dire que c’est un pli, une fronce ou un papillon, n’a aucun rapport avec l’évolution des paramètres. Ou du moins leur mode d’évolution. Un pli, par exemple, n’implique pas que le système se replie sur lui-même. Ce sont les paramètres qui décrivent topologiquement un pli, et non le système.

Je me souviens d’une conférence donnée par René Thom à Jussieu sur le rapport entre « Tectonique des plaques et théorie des catastrophes », publiée dans « Astérisque » (1978, #59-60, 205-231). L’idée, dans l’esprit de Claude Allègre, qui l’invitait, était d’exposer une vision « platonicienne », par opposition à une vision « réductionniste » qui vise à une explication ultime de la forme comme agrégation d'éléments primitifs aux propriétés supposées connues. Après une discussion sur la rigidité des plaques, qui, on le sait depuis, est toute relative, car elles se déforment avec le temps, viscosité lente, mais efficace, il en arrive à la théorie des catastrophes, avec des points de singularité, c’est-à-dire des discontinuités, dans les diagrammes de vitesse des différents points d’une plaque. Cette variété mathématique et/ou physique se caractérise par sa non-définition en ce point, soit par son impossibilité à la définir (ex. la fonction 1/x pour x = 0), ou à la caractériser (ex. un point de fronce). En littérature, on trouve le terme dans l’excellent premier roman de Sergio de la Pava « A Naked Singularity » (une singularité nue), roman policier traduit par Claro dans la collection Lot49 (2016, Cherche Midi, 850 p.) qui met en scène un brillant avocat qui organise un braquage, soit-disant non susceptible d’être inquiété par la police.

Puis, René Thom présente des exemples de catastrophes, au sens topologique des fonctions, décrivant des arêtes, avec des changements de vitesse brutaux le long de failles transformantes (par exemple celle de San Andreas, en Californie). Ou bien, des points triples, où plusieurs plaques se rencontrent. Ce qui en fait une approche originale du volcanisme, décrit comme instabilité de vitesse, et donc une zone de conflit entre compression et extension. Il est évident que la topologie d’un champ de vitesse est mal identifiée par rapport au champ de contraintes habituel. D’où une discussion houleuse entre le conférencier et son hôte.

Il se trouve que le vendredi suivant, je prenais mon train à Montparnasse pour rentrer chez moi à Nantes. Passant devant le parvis, j’ai aperçu René Thom à une terrasse. La table à côté étant libre, je me suis assis et lui ai reparlé de sa conférence de Jussieu. Il m’a expliqué très clairement, m’a envoyé par la suite un tiré à part de son article. Evidemment c’était une confusion entre la topologie du système et sa forme géométrique. Le pli et la fronce caractérisaient le diagramme des paramètres et non pas la déformation du milieu.

De fait, la curiosité de René Thom pour la complexité provient de sa prime jeunesse et de sa passion pour les trains électriques. « J'ai certainement perdu beaucoup de temps ravi par la fascination ferroviaire ; mais, en y repensant par la suite, je ne suis pas éloigné de croire que j'ai trouvé dans cette contemplation infantile quelques-uns des ressorts les plus profonds et les plus secrets de mes intuitions de mathématicien topologue et de philosophe catastrophiste. J'y ai en tout cas trouvé cette idée essentielle : un réseau, dans sa structure "cybernétique" d'événements agissant les uns sur les autres, n'est jamais arbitraire. Il y a toujours une dynamique continue sous-jacente qui l'engendre et l'organise, faute de retrouver cette interprétation originaire, l'approche combinatoire, systémique, reste à la surface des choses ». On a eu de la chance, il aurait pu s’orienter sur les déraillements.

Pour ce qui est de l’application de sa théorie à la morphogenèse, Thom commence par remettre en cause les paradigmes « La synthèse [...] des pensées « vitaliste » et « mécaniste » en Biologie n'ira pas sans un profond remaniement de nos conceptions du monde inanimé. On use sans trop de scrupules en Biologie (et surtout en Biologie Moléculaire !) de vocables anthropomorphes tels que : information, code, message, programme [...] En pure Physicochimie, l'usage de ces vocables serait considéré comme la manifestation d'un anthropomorphisme délirant ». C’est bien un mathématicien qui parle et qui écrit. Avant d’introduire son modèle qui « attribue toute morphogenèse à un conflit, à une lutte entre deux ou plusieurs « attracteurs » ». Le mot est lâché, avant qu’il ne soit repris par les idées de complexité et de dynamique des systèmes.

René Thom s’inspire pour cela de d'Arcy Thompson (1860-1948), et de son « On Growth and Form » (1917), traduit en « Forme et Croissance » (2009, Seuil, 336 p.). Il s’agit d’un ouvrage fondamental dans la morphogenèse et le développement des formes vivantes. Pour cela, Thom ne se confine pas au numérique, mais retourne au géométrique, plus intuitif et qualitatif et intuitif, et fonde ainsi une dynamique des formes. Il insiste alors sur le concept de bord. « Pour Aristote, un être, en général, c'est ce qui est là, séparé. Il possède un bord, il est séparé de l'espace ambiant. En somme, le bord de la chose, c'est sa forme. Le concept, lui aussi, a un bord : c'est la définition de ce concept ». En mathématiques, le bord est ce qui peut être abordé, à la fois par l’intérieur et l’extérieur de cet ensemble. A côté de ce bord, il ajoute une « boîte noire », liée au paradigme existant en biologie ou aux fonctions relationnelles. Enfin il prend en compte l'autonomie des niveaux d'émergence, c’est-à-dire le « vitalisme géométrique » et la réduction des niveaux de complexité. C’est très technique et fait appel à un « champ morphogénétique », aptitude structurante d'un système, un « attracteur », pour stabiliser la forme un état perturbé, et enfin une « épigénétique », ou variation de la complexité du système.

René Thom explique l'analogie des formes par l'isomorphisme des situations dynamiques de conflit qui les engendre. Le lieu des discontinuités, alors nommé morphologie, définit le bord d'une forme qualitative, phénoménologique et dynamique. Une catastrophe correspond aux valeurs critiques des paramètres morphogénétiques qui produisent une variation rapide de l'état du système. C’est ainsi que le pli correspond à un bord, soit la fin ou l’apparition d'un attracteur. La fronce résulte de la bifurcation d'un attracteur en deux autres. L'ombilic elliptique contrôle les formes pointues alors que l’ombilic parabolique éclate cette pointe en pointes complémentaires, et que l’ombilic hyperbolique provoque un déferlement latéral, similaire à une vague. On constate alors l’ambiguïté qu’il peut y avoir entre le type de catastrophe, topologie des paramètres, et la topologie des systèmes. En effet, le type de catastrophe, (pli, fronce, ombilic…) est défini sur les paramètres. Dans la morphogenèse, voilà cette forme mise au niveau de la morphologie du système. En d’autres termes, avec un exemple, prenons le cas d’une transition de phase, la transformation d’eau en glace. Il y a bien 1 paramètre, la viscosité de l’eau qui se transforme en 2, celle de l’eau et celle des glaçons. On a bien affaire à une catastrophe de type pli. Par contre, la forme du glaçon n’a rien à voir avec un quelconque pli. Mais on est passé de la catastrophe à la morphogenèse. Il y a là, à mon avis, un saut interprétatif qui m’échappe.

Il faut dire que lors de l’apparition de la théorie, le monde scientifique et surtout les SHS, ont vu des applications un peu partout, en linguistique comme en biologie, de la génération des ocelles sur les ailes de papillon à l’acquisition du langage humain. Il en a été de même plus tard avec l’apparition de la percolation dans les phénomènes de transport. Ou avec les fractales et l’apparition du chaos. Ce sont parfois des modes, plus ou moins assimilées, qui servent de supports analogiques à des théories mal appréhendées. Les modes aussi existent en sciences, mais étonnamment, on n’a pas encore revisité la roue.

Avec cette théorie de la morphogenèse, Thom rompt avec le courant néodarwiniste et réductionniste, admettant aussi que c’est « le défaut propre de tout modèle qualitatif par rapport aux modèles quantitatifs classiques ». C’est par évidence antithétique du Darwinisme. « Pourquoi un animal a-t-il la forme qu'il a ? Darwin répond : parce qu'il a, approximativement, la même forme que ses parents. [...] Comment de nouvelles formes, de nouvelles espèces ont pu apparaître [...] ? La sélection darwinienne permettait de se passer du Créateur, et ce fut indiscutablement son immense mérite historique. [...] C'est cet aspect tout négatif de la pensée darwinienne - éliminer Dieu - qui finalement a assuré son triomphe ».

L’innovation de René Thom consiste ensuite à généraliser les modèles morpho-dynamiques en biologie à une morpho-dynamique en linguistique ou sémiotique. L’idée centrale est que la continuité des lois morphogénétiques dans le domaine du vivant relie la physiologie et ses formes symboliques, dont le langage. C’est alors une sorte de « naturalisme méthodologique ». Il effectue alors une synthèse entre un processus généré par des bords et un espace continu, brisant alors les symétries et faisant apparaître le discontinu dans le continu.

On pense immédiatement au travail de Alexandre Grothendieck (1928-2014) et sa « géométrie algébrique », réunification de deux mondes jadis séparés que sont l’algèbre, ou les nombres, discontinus, et la géométrie et ses courbes continues. On lira, peut avec quelques difficultés, « Récoltes et Semailles » sous-titré « Réflexions et témoignage sur un passé de mathématicien ». C’est une collection de textes et d’essais finalement parue en deux tomes, réunis en un coffret de format poche (2023, Gallimard, Tel #742, 1998 p.).

L’exemple que Grothendieck fournit est illustré par le passage de mots aux vers, qu’il découvre étant enfant. Exemple certainement pas choisi au hasard. Il illustre son propos par le passage du mot à la phrase, belle illustration du passage du discontinu au continu. Chose simple, « jusqu’au jour où quelqu’un m’a expliqué qu’il y avait un "truc" tout simple ; que la rime, c’est tout simplement quand on fait se terminer par la même syllabe deux mouvements parlés consécutifs, qui du coup, comme par enchantement, deviennent des vers ». C’est la même variété de topologie.

René Thom (1923-2002) est un jurassien d’origine, de Montbéliard en particulier, qui passe par l’Ecole Normale Supérieure, avant d’obtenir son doctorat en 1951 à Paris sous la direction, et la canalisation, d’Henri Cartan. Il sera professeur à la Faculté des Sciences de Strasbourg de 1954 à 1963. Recevant un prix Medal Fields en 1958 sur la topologie différentielle, avant d’intégrer l’« Institut des Hautes Etudes Scientifiques » (IHES) de Bures-sur-Yvette de 1963 à 1990. Il y est en bonne compagnie, puisqu’il y a là Alexandre Grothendieck, puis Pierre Deligne et Alain Connes, tous Medal Fields. C’est vraiment l’âge d’or de ce centre des sciences. Pour ce qui concerne Grothendieck, j’ai récemment relu et commenté les deux tomes de son ouvrage « Récoltes et Semailles » un pavé de 2000 pages (2023, Gallimard, 1506 p.). A vrai dire, je profite du centenaire de sa naissance pour réactualiser ces fiches de lecture.

Son premier ouvrage « Stabilité structurelle et morphogenèse » est le premier, je crois, destiné au grand public sur la théorie des catastrophes (1977, Interéditions, 382 p.). Il a été réédité plusieurs fois par la suite.

L’ouvrage actuel fournit des modèles d'explications scientifiques de la théorie des catastrophes. Il aborde les questions de sémantique, ou plus simplement la signification des signes, spécifiquement dans le langage. Tout cela à partir de problèmes de topologie. L’intérêt de l’ouvrage est de présenter une étude précise et très documentée sur la réalité et les limites de l'utilisation de ces concepts. « L’idée essentielle de notre théorie, à savoir qu’une certaine compréhension des processus morphogénétiques est possible sans avoir recours aux propriétés spéciales au substrat des formes, ou à la nature des forces agissantes, pourra sembler difficile à admettre, surtout de la part d’expérimentateurs habitués à tailler dans le vif, et continuellement en lutte avec une réalité qui leur résiste ».

L’idée part en partie d’un ouvrage de Alan Turing intitulé « The Chemical Basis of Morphogenesis » publié dans « Philosophical Transactions of the Royal Society B Biological Sciences » (1952, Phil. Trans. Royal Soc. B237, 37-72). C’est le A.M. Turing (1912-1954) mathématicien britannique, auteur de travaux qui fondent scientifiquement la cryptographie. C’est aussi un des pionniers de l'Intelligence artificielle. Il se suicide en 1954 pour éviter d’être poursuivi pour homosexualité. Ila cependant été anobli par la reine.

Dans cet article, Turing décrit comment des motifs peuvent apparaitre dans la nature à partir d’un état homogène et uniforme ? Ces motifs (patterns) incluent des rayures et des spirales, comme les raies du zèbre. Cela suppose des réactions chimiques appelées de « réaction-diffusion ». On pourra lire à ce sujet l’épais ouvrage de James D Murray « Mathematical Biology » (2007, Springer, 781 p.) qui explique pourquoi la moufette a un corps noir avec une queue et un dos blanc. Le même bicolorisme était observé chez le ramoneur savoyard, mais la différence résidait surtout en ce qu’il portait souvent une petite échelle.

Cette physico-chimie de réaction-diffusion est basée sur une interaction entre la diffusion d’un pigment et le taux de réaction chimique, et quoiqu’elle s’applique facilement à des géométries simples, elle est plus complexe à simuler des patterns irréguliers. C’est là que la théorie de la morphogenèse de René Thom intervient. « La science naît du jour où des erreurs, des échecs, des surprises désagréables, nous poussent à regarder le réel de plus près ».

Le traitement mathématique de ce problème s’applique à de nombreux autres domaines comme l’hydrodynamique, la cristallographie, la géophysique, ou la dynamique des populations, pour n’en citer que ces exemples. Cela reflète l’existence de « classes d’universalité » des formes et de leur apparition dans les systèmes naturels.

Cependant, certaines formes, comme la structure alvéolaire de la cire d’abeille dans les ruches, procède de raisons différentes. En effet, dans ce cas, la structure hexagonale est celle qui nécessite le moins de cire pour produire le maximum d’espace libre. Il suffit de calculer les périmètres respectifs des triangles, carrés et hexagones et de constater que les abeilles construisent à l’économie.

René Thom identifie et individualise différents types de catastrophes élémentaires, suivant le nombre de paramètres impliqués, et selon le degré de la courbe qui contrôle le potentiel d’un système. Ce dernier est facile à conceptualiser. Une courbe du second degré (n = 2), par exemple une parabole, admet un seul point minimum ou maximum, selon sa concavité. Pour simplifier, on choisira une courbe à concavité vers le bas. Ce point minimum va représenter le point se stabilité du système. Par contre, si on considère une courbe de degré quatre (n = 4), elle possède deux points minimum, séparés par un maximum. Il faut imaginer une bille roulant sur cette courbe. Le maximum est un point instable. Par contre, les deux minima peuvent être considérés comme stables, à condition que l’on ne vienne pas perturber la bille.

Passant de la courbe unidimensionnelle V = f(x) à la surface V = f(x, y), on obtient ainsi les sept formes de « catastrophes » possibles, suivant leur degré et le nombre de paramètres que sont les coefficients des équations, qui contrôlent les minima des courbes. On a ainsi le pli, la plus simple des formes en degré 3 à un seul paramètre. Si deux paramètres existent, et que la courbe est de degré 4, il s’agit d’une fronce. Pour trois paramètres en entrée, et une variable, il s’agit de la queue d’aronde. Pour deux variables, c’est un ombilic hyperbolique (vague) ou elliptique (poil) selon son comportement à l’infini. Enfin, pour quatre paramètres on aura un papillon si c’est une courbe, à une variable ou un champignon, ombilic parabolique si c’est une surface. Avec plus de paramètres, d’autres formes de catastrophes distinctes apparaissent.

On constate donc de suite que le nombre de variables (x) ou (x, y) va déterminer si c’est une courbe ou une surface. Par contre, le nombre de paramètres joue sur le nombre et la position des points d’équilibre ou d’instabilité, suivant la concavité des courbes.

Et c’est là que tout est parti en catastrophe, c’est le cas de le dire. La théorie de René Thom est essentiellement une description mathématique d’un passage entre deux situations, c’est la description d‘une bifurcation dynamique. Le système passe brutalement d’un état à un autre, c’est la notion de catastrophe. Par contre, dire que c’est un pli, une fronce ou un papillon, n’a aucun rapport avec l’évolution des paramètres. Ou du moins leur mode d’évolution. Un pli, par exemple, n’implique pas que le système se replie sur lui-même. Ce sont les paramètres qui décrivent topologiquement un pli, et non le système.

Je me souviens d’une conférence donnée par René Thom à Jussieu sur le rapport entre « Tectonique des plaques et théorie des catastrophes », publiée dans « Astérisque » (1978, #59-60, 205-231). L’idée, dans l’esprit de Claude Allègre, qui l’invitait, était d’exposer une vision « platonicienne », par opposition à une vision « réductionniste » qui vise à une explication ultime de la forme comme agrégation d'éléments primitifs aux propriétés supposées connues. Après une discussion sur la rigidité des plaques, qui, on le sait depuis, est toute relative, car elles se déforment avec le temps, viscosité lente, mais efficace, il en arrive à la théorie des catastrophes, avec des points de singularité, c’est-à-dire des discontinuités, dans les diagrammes de vitesse des différents points d’une plaque. Cette variété mathématique et/ou physique se caractérise par sa non-définition en ce point, soit par son impossibilité à la définir (ex. la fonction 1/x pour x = 0), ou à la caractériser (ex. un point de fronce). En littérature, on trouve le terme dans l’excellent premier roman de Sergio de la Pava « A Naked Singularity » (une singularité nue), roman policier traduit par Claro dans la collection Lot49 (2016, Cherche Midi, 850 p.) qui met en scène un brillant avocat qui organise un braquage, soit-disant non susceptible d’être inquiété par la police.

Puis, René Thom présente des exemples de catastrophes, au sens topologique des fonctions, décrivant des arêtes, avec des changements de vitesse brutaux le long de failles transformantes (par exemple celle de San Andreas, en Californie). Ou bien, des points triples, où plusieurs plaques se rencontrent. Ce qui en fait une approche originale du volcanisme, décrit comme instabilité de vitesse, et donc une zone de conflit entre compression et extension. Il est évident que la topologie d’un champ de vitesse est mal identifiée par rapport au champ de contraintes habituel. D’où une discussion houleuse entre le conférencier et son hôte.

Il se trouve que le vendredi suivant, je prenais mon train à Montparnasse pour rentrer chez moi à Nantes. Passant devant le parvis, j’ai aperçu René Thom à une terrasse. La table à côté étant libre, je me suis assis et lui ai reparlé de sa conférence de Jussieu. Il m’a expliqué très clairement, m’a envoyé par la suite un tiré à part de son article. Evidemment c’était une confusion entre la topologie du système et sa forme géométrique. Le pli et la fronce caractérisaient le diagramme des paramètres et non pas la déformation du milieu.

De fait, la curiosité de René Thom pour la complexité provient de sa prime jeunesse et de sa passion pour les trains électriques. « J'ai certainement perdu beaucoup de temps ravi par la fascination ferroviaire ; mais, en y repensant par la suite, je ne suis pas éloigné de croire que j'ai trouvé dans cette contemplation infantile quelques-uns des ressorts les plus profonds et les plus secrets de mes intuitions de mathématicien topologue et de philosophe catastrophiste. J'y ai en tout cas trouvé cette idée essentielle : un réseau, dans sa structure "cybernétique" d'événements agissant les uns sur les autres, n'est jamais arbitraire. Il y a toujours une dynamique continue sous-jacente qui l'engendre et l'organise, faute de retrouver cette interprétation originaire, l'approche combinatoire, systémique, reste à la surface des choses ». On a eu de la chance, il aurait pu s’orienter sur les déraillements.

Pour ce qui est de l’application de sa théorie à la morphogenèse, Thom commence par remettre en cause les paradigmes « La synthèse [...] des pensées « vitaliste » et « mécaniste » en Biologie n'ira pas sans un profond remaniement de nos conceptions du monde inanimé. On use sans trop de scrupules en Biologie (et surtout en Biologie Moléculaire !) de vocables anthropomorphes tels que : information, code, message, programme [...] En pure Physicochimie, l'usage de ces vocables serait considéré comme la manifestation d'un anthropomorphisme délirant ». C’est bien un mathématicien qui parle et qui écrit. Avant d’introduire son modèle qui « attribue toute morphogenèse à un conflit, à une lutte entre deux ou plusieurs « attracteurs » ». Le mot est lâché, avant qu’il ne soit repris par les idées de complexité et de dynamique des systèmes.

René Thom s’inspire pour cela de d'Arcy Thompson (1860-1948), et de son « On Growth and Form » (1917), traduit en « Forme et Croissance » (2009, Seuil, 336 p.). Il s’agit d’un ouvrage fondamental dans la morphogenèse et le développement des formes vivantes. Pour cela, Thom ne se confine pas au numérique, mais retourne au géométrique, plus intuitif et qualitatif et intuitif, et fonde ainsi une dynamique des formes. Il insiste alors sur le concept de bord. « Pour Aristote, un être, en général, c'est ce qui est là, séparé. Il possède un bord, il est séparé de l'espace ambiant. En somme, le bord de la chose, c'est sa forme. Le concept, lui aussi, a un bord : c'est la définition de ce concept ». En mathématiques, le bord est ce qui peut être abordé, à la fois par l’intérieur et l’extérieur de cet ensemble. A côté de ce bord, il ajoute une « boîte noire », liée au paradigme existant en biologie ou aux fonctions relationnelles. Enfin il prend en compte l'autonomie des niveaux d'émergence, c’est-à-dire le « vitalisme géométrique » et la réduction des niveaux de complexité. C’est très technique et fait appel à un « champ morphogénétique », aptitude structurante d'un système, un « attracteur », pour stabiliser la forme un état perturbé, et enfin une « épigénétique », ou variation de la complexité du système.

René Thom explique l'analogie des formes par l'isomorphisme des situations dynamiques de conflit qui les engendre. Le lieu des discontinuités, alors nommé morphologie, définit le bord d'une forme qualitative, phénoménologique et dynamique. Une catastrophe correspond aux valeurs critiques des paramètres morphogénétiques qui produisent une variation rapide de l'état du système. C’est ainsi que le pli correspond à un bord, soit la fin ou l’apparition d'un attracteur. La fronce résulte de la bifurcation d'un attracteur en deux autres. L'ombilic elliptique contrôle les formes pointues alors que l’ombilic parabolique éclate cette pointe en pointes complémentaires, et que l’ombilic hyperbolique provoque un déferlement latéral, similaire à une vague. On constate alors l’ambiguïté qu’il peut y avoir entre le type de catastrophe, topologie des paramètres, et la topologie des systèmes. En effet, le type de catastrophe, (pli, fronce, ombilic…) est défini sur les paramètres. Dans la morphogenèse, voilà cette forme mise au niveau de la morphologie du système. En d’autres termes, avec un exemple, prenons le cas d’une transition de phase, la transformation d’eau en glace. Il y a bien 1 paramètre, la viscosité de l’eau qui se transforme en 2, celle de l’eau et celle des glaçons. On a bien affaire à une catastrophe de type pli. Par contre, la forme du glaçon n’a rien à voir avec un quelconque pli. Mais on est passé de la catastrophe à la morphogenèse. Il y a là, à mon avis, un saut interprétatif qui m’échappe.

Il faut dire que lors de l’apparition de la théorie, le monde scientifique et surtout les SHS, ont vu des applications un peu partout, en linguistique comme en biologie, de la génération des ocelles sur les ailes de papillon à l’acquisition du langage humain. Il en a été de même plus tard avec l’apparition de la percolation dans les phénomènes de transport. Ou avec les fractales et l’apparition du chaos. Ce sont parfois des modes, plus ou moins assimilées, qui servent de supports analogiques à des théories mal appréhendées. Les modes aussi existent en sciences, mais étonnamment, on n’a pas encore revisité la roue.

Avec cette théorie de la morphogenèse, Thom rompt avec le courant néodarwiniste et réductionniste, admettant aussi que c’est « le défaut propre de tout modèle qualitatif par rapport aux modèles quantitatifs classiques ». C’est par évidence antithétique du Darwinisme. « Pourquoi un animal a-t-il la forme qu'il a ? Darwin répond : parce qu'il a, approximativement, la même forme que ses parents. [...] Comment de nouvelles formes, de nouvelles espèces ont pu apparaître [...] ? La sélection darwinienne permettait de se passer du Créateur, et ce fut indiscutablement son immense mérite historique. [...] C'est cet aspect tout négatif de la pensée darwinienne - éliminer Dieu - qui finalement a assuré son triomphe ».

L’innovation de René Thom consiste ensuite à généraliser les modèles morpho-dynamiques en biologie à une morpho-dynamique en linguistique ou sémiotique. L’idée centrale est que la continuité des lois morphogénétiques dans le domaine du vivant relie la physiologie et ses formes symboliques, dont le langage. C’est alors une sorte de « naturalisme méthodologique ». Il effectue alors une synthèse entre un processus généré par des bords et un espace continu, brisant alors les symétries et faisant apparaître le discontinu dans le continu.

On pense immédiatement au travail de Alexandre Grothendieck (1928-2014) et sa « géométrie algébrique », réunification de deux mondes jadis séparés que sont l’algèbre, ou les nombres, discontinus, et la géométrie et ses courbes continues. On lira, peut avec quelques difficultés, « Récoltes et Semailles » sous-titré « Réflexions et témoignage sur un passé de mathématicien ». C’est une collection de textes et d’essais finalement parue en deux tomes, réunis en un coffret de format poche (2023, Gallimard, Tel #742, 1998 p.).

L’exemple que Grothendieck fournit est illustré par le passage de mots aux vers, qu’il découvre étant enfant. Exemple certainement pas choisi au hasard. Il illustre son propos par le passage du mot à la phrase, belle illustration du passage du discontinu au continu. Chose simple, « jusqu’au jour où quelqu’un m’a expliqué qu’il y avait un "truc" tout simple ; que la rime, c’est tout simplement quand on fait se terminer par la même syllabe deux mouvements parlés consécutifs, qui du coup, comme par enchantement, deviennent des vers ». C’est la même variété de topologie.

Dans cet entretien avec Émile Noël, René Thom se livre simplement et sans complaisance sur son parcours de mathématicien. Il revient sur sa formation et bien entendu sur sa fameuse théorie des catastrophes. Il insiste sur le rôle qualitatif des mathématiques. Du coup, il ressort de ce discours, dans lequel René Thom fait toujours preuve d'une grande modestie, une certaine "poétique des mathématiques" comme l'écrivait si joliment Manuel de Dieguez dans "Sciences et nescience".

Un livre à lire pour tous ceux qui comme moi ne sont pas mathématicien, mais qui souhaitent malgré tout comprendre la pensée d'un mathématicien contemporain dont on n'a cessé de parler depuis les années 1970.

Un livre à lire pour tous ceux qui comme moi ne sont pas mathématicien, mais qui souhaitent malgré tout comprendre la pensée d'un mathématicien contemporain dont on n'a cessé de parler depuis les années 1970.

Les Dernières Actualités

Voir plus

Auteurs proches de René Thom

Quiz

Voir plus

Fleurs, fruits, livres, chansons 🌸🍓📘🎶

Quelle chaleur!😓 Heureusement, j'ai gardé une ... pour la soif.

pomme

poire

10 questions

348 lecteurs ont répondu

Créer un quiz sur cet auteur348 lecteurs ont répondu